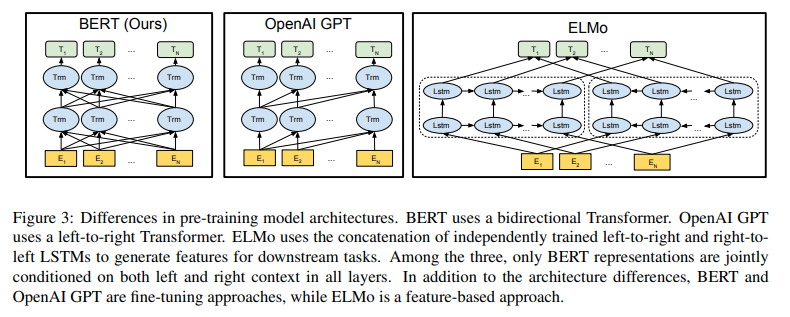

BERT

BERTとはBidirectional Encoder Representations from Transformersの略語で、自然言語処理技術(NLP)モデルの一つです。2018年にgoogle社のJacob Devlinらにより「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」という論文に発表されました。BERTモデルの特徴として、双方向のTransformerが持っていることで、分析対象の単語の前後文章の関連性を重視しています。それ故に普通の自然言語処理アルゴリズムより精度が高いです。

出典「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」

- ~目次~

- 1.注目された背景

- 2.メリットとデメリット

- 3.運用事例

1.注目された背景

IT技術発展している現在の社会では、IT技術は生活の各所にも応用されていて、生活も便利になっています。このような環境の中で、より更なるIT技術の進歩が求められています。このような中で、人間の知恵を備えるAI技術は関心を集めています。簡単なアルゴリズムだけではなく、人間のように勉強することができます。そのためにAI技術を生活中に応用することは各分野で実現したいことになっています。

例えば話すだけでパソコンでの文字入力ができるようになっているのはAIの音声認識技術です。また外観検査でよく使われている画像認識技術など人の代わりに人間のように作業しています。今回で紹介するBERTは検索エンジンなどの自然言語処理分野で使われています。

研究者の方々の努力によりAI技術はどんどん進化しています。例えば以前の検索エンジンの検索結果は今現在の検索結果と比較すると、今現時点の検索結果の精度の方が高いです。AIを進化させて、人々の生活をより便利にするために、BERTが誕生しました。従来のモデルに基づいて、アルゴリズムを改善されたことで、自然言語処理の精度を一気に高められました。

2.メリットとデメリット

- メリット:

-

1.事前学習を備えている双方向モデルのため、従来の自然言語処理モデルより精度が高いです

2.自然言語処理で、文書の傾向性や、内容類似文章抽出の精度が高いです。 - デメリット:

- 他のAIと同じく実際の現場導入にあたってトレーニングは大量のデータが必要となります。

3.運用事例

先ほど述べたように、BERTは主に自然言語処理分野で使われています。先ほどと同じく検索エンジンの例を言いますと、毎回入力されたワードとクリックした検索結果両方のデータを持ち学習させることで、AIのアルゴリズムは人間のようにそのワードと探したいことを分析し、そのワードの傾向に近いもの、探ししたいものを出せるようになっています。

また、営業のDX化にも応用できます。例えばカスタマーサポートのチャットボットが挙げられます。自社カスタマーサポートの方や営業の方はお客様と話しした内容をデータ化にして、AIで分析することで、顧客のメッセージが来ましたら、一番適切な返信が送れるようになります。

▼レポート無料ダウンロード お申し込みはこちら▼